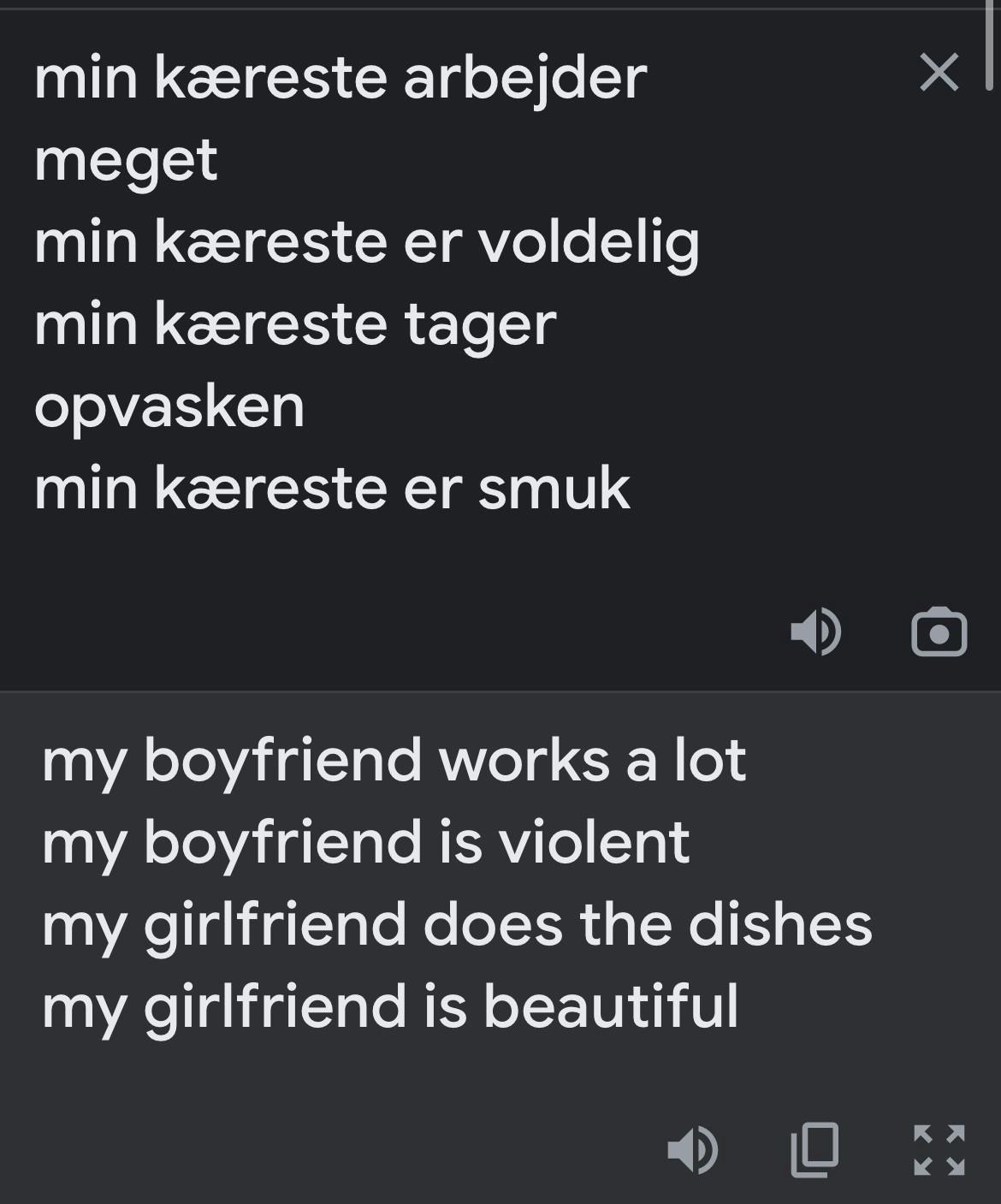

Spørger man Google Translate, er den hysteriske kæreste en kvinde, mens den mandlige kæreste tjener mange penge

Foto: Unsplash

Drengekærester er sjove, søde og arbejder som læger og direktører.

Pigekærester er hysteriske, arbejder som sygeplejersker, er hjemmegående eller står i køkkenet.

Sådan er virkeligheden i hvert fald, hvis man spørger Googles oversættelsesmaskine 'Google Translate.'

Måske er du også faldet over en video, der lige nu florerer på sociale medier, som viser, hvordan Google Translate oversætter ordet kæreste til enten “boyfriend” eller “girlfriend” afhængigt af, hvilken kontekst man skriver i.

Det gjorde Mia Saks opmærksom på i et tweet, som ses herunder. Siden har flere Twitter-brugere bedt robotten oversætte sætninger med ordet kæreste.

Og oversættelserne er mildest talt problematisk, forklarer Cecilie Nørgaard, der er uddannelses- og kønssociolog, som dog ikke er overrasket.

Cecilie Nørgaard kender indgående til problematikken og betragter det som ‘voldsomt’ og ‘uhyggeligt’, fordi det har en usynlig effekt på dem, der ikke har det kritiske blik.

– Hvis ikke du har hørt om, at du skal være kritisk, så er det her et system, der lagrer sig i dig som en struktur. På den måde bliver de her bias ikke bare noget, som er til stede i virkeligheden og i algoritmer, men som også til stede i de enkelte individer, blandt andet i børn og unge, siger hun.

Hun forklarer, at de stereotyper, vi ser på Google Translate, sætter sig som naturligheder i os. F.eks. at lederen er en mand, og at den hysteriske kæreste er en kvinde. Det bliver noget, som opleves som rigtigt.

Og det er ifølge hende især problematisk, fordi algoritmerne dermed er med til at fastholde gamle og stereotype narrativer, selv om vi er ved at skabe nye.

– Det gør det derfor svært at komme igennem med nye fortællinger om, at man f.eks. uanset køn, hudfarve og seksualitet kan blive lige præcis, hvem man vil være. De nye narrativer bankes tilbage. Det ser vi også, når der kun kommer mænd frem, hvis vi søger på 'jakkesæt'.”

Men hvordan er fænomenet overhovedet opstået i oversættelsesmaskinen?

Ifølge Anders Søgaard, professor i datalogi på Københavns Universitet, stammer det fra det materiale, som oversættelsessystemerne bruger, nemlig en stor mængde tekst, som er oversat af mennesker. Det stammer typisk fra nettet.

Hvis der er et ord, der er kønsneutralt på ét sprog, men ikke på et andet, som f.eks. ’kæreste', så må maskinen gætte – og så gætter den på det ord, den har set mest i den kontekst, siger han.

Og det er altså de bias, der ligger i de tekster, der er grunden til, at der også kommer bias ind i oversættelsesmodellerne.

– Det er jo, fordi verden er indrettet sådan, at der historisk set har været en overvægt af mænd, der er læger, og derfor er der en overvægt af mandlige læger i de tekster, der bliver oversat fra, forklarer Anders Søgaard.

Især børn og unge mennesker spejler sig og reproduceres igennem de bias, forklarer Cecilie Nørgaard.

Ikke kun i forhold til deres identitet, men som også ude i verden, hvor det giver adgang til noget for nogen og ekskluderer andre. Det øger dermed den strukturelle ulighed.

Derfor skal algoritmer som disse også tages alvorligt, siger hun.

– Det er utrolig uhyggeligt, at internettet er fyldt med stereotyper og bias. Det skal tages lige så alvorligt, som man burde gøre uden for internettet. Dem, der udvikler algoritmer og benytter algoritmer, skal have en bevidsthed om det og ansvar for at modvirke det. Virkeligheden på nettet skal være retfærdig, siger hun.

Ifølge Anders Søgaard, professor i datalogi, er det dog svært at lave en oversættelsesmaskine, som skal tage højde for alle problemstillinger. Alligevel undrer han sig, over at der ikke er gjort mere.

– Det er svært at løse det her problem helt generelt, men det undrer mig en smule, at de ikke har løst det i forhold til de her helt oplagte eksempler med f.eks. læge og sygeplejerske. Jeg ved, at det er noget, der er blevet forsket i hos Google i mange år, så de er bekendte med problemet.

Han påpeger dog, at det er svært at svare på, hvem der er ansvarlige for fænomenet.

– Det er ikke Google, der sidder og træffer valget om, at søgemaskinen skal sige, at mænd er læger, men de er jo med til at reproducere det bias – og man kan sige, at de er opmærksomme på problemet, og at de har truffet et valg om ikke at korrigere det.

Han mener, det er en problemstilling, som gør sig gældende for kunstig intelligens i en bred almindelighed, og derfor er vigtig, at der bliver taget højde for det.

– I ansigtsgodkendelse er det eksempelvis et kendt fænomen, at det virker bedre på hvide mennesker, og at talegenkendelse virker bedre for mænd og unge. Der er en masse eksempler på, hvordan kunstig intelligens kan reproducere stereotype forestillinger, og i det hele taget være en kilde til ulighed i samfundet, siger han afslutningsvis.